GROMACS

Deskripsi

GROMACS adalah package berkecepatan tinggi untuk komputasi dinamika molekular baik untuk biokimia (seperti protein, lipids) maupun non-biokimia (seperti polimer).

Versi yang Tersedia

| Versi | Nama Modul | Dukungan MPI | Dukungan Hardware | Partisi |

|---|---|---|---|---|

| 2021.1 | gromacs | Hybrid MPI/OMP | CPU-GPU

parallel multi-node |

epyc

gpu_ampere |

Menjalankan Perintah Interaktif GROMACS di Terminal

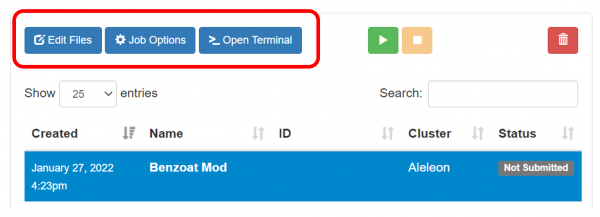

Beberapa perintah GROMACS bekerja secara interaktif dan membutuhkan input dari user (contoh: pdb2gmx, grompp) sehingga harus dijalankan via terminal atau menu Open Terminal. Adapun untuk perintah mdrun harus dijalankan via Job Composer.

Sebelum melakukan perintah interaktif GROMACS, load module GROMACS:

$ module load gromacs

Lanjutkan dengan melakukan perintah interaktif GROMACS (contoh: pdb2gmx):

$ gmx_mpi pdb2gmx <parameter_input_dan_output>

Menjalankan GROMACS via Job Composer

Test

Contoh SLURM Script

User harus menggunakan manajemen SLURM untuk menjalankan komputasi GROMACS di Compute Node. User dapat menjalankan GROMACS dengan satu node atau paralel (lebih dari satu node) untuk performa lebih kencang.

Satu Node CPU

Contoh berikut untuk menjalankan GROMACS pada satu node CPU.

#!/bin/bash #SBATCH --ntasks=64 # Contoh menggunakan 64 core CPU #SBATCH --mem=128GB # Contoh menggunakan RAM 128GB #SBATCH --time=10:00:00 # Contoh menetapkan walltime maks 10 jam #SBATCH --output=result-%j.out # Output terminal program #SBATCH --error=result-%j.err # Output verbose program # Memuat modul GROMACS module load gromacs # RUN COMMAND # mpirun wajib menggunakan flag protokol UCX mpirun -np $SLURM_NTASKS --mca pml ucx --mca osc ucx gmx_mpi mdrun <parameter_input_dan_output>

Multi Node CPU

Contoh berikut untuk menjalankan GROMACS pada lebih dari satu node CPU.

#!/bin/bash

#SBATCH --nodes=2 # Contoh menggunakan 2 node ...

#SBATCH --ntasks-per-node=64 # dengan 64 core per node.

# Maka dari itu total menggunakan 128 core CPU

#SBATCH --mem=128GB # Contoh menggunakan RAM 128GB per node

#SBATCH --time=10:00:00 # Contoh menggunakan walltime maks 10 jam

#SBATCH --output=result-%j.out # Output terminal program

#SBATCH --error=result-%j.err # Output verbose program

# Memuat modul GROMACS

module load gromacs

# RUN COMMAND

# mpirun wajib menggunakan flag protokol UCX

# $SLURM_NTASKS menangkap total proses MPI (nodes * ntasks-per-node)

mpirun -np $SLURM_NTASKS --mca pml ucx --mca osc ucx gmx_mpi mdrun <parameter_input_dan_output>

Akselerasi Satu GPU di GPU Node

User juga dapat menjalankan pekerjaan di GPU node menggunakan resource GPU. Perlu diketahui tidak semua input dan parameter berjalan kencang dengan akselerasi GPU. Harap user dapat menguji terlebih dahulu mdrun-nya dengan nsteps kecil untuk mengetahui peningkatan performa yang bisa diperoleh melalui akselerasi GPU. Perlu diketahui pula akselerasi GPU umumnya hanya bisa berjalan dengan hybrid OpenMP.

Biasanya, GROMACS mdrun tidak memerlukan parameter tambahan untuk menjalankan akselerasi GPU. Namun dalam beberapa kasus, optimasi menggunakan parameter tambahan bisa berpengaruh positif ke kecepatan komputasi. Referensi mengenai parameter akselerasi GPU lanjutan (-nb, -bonded, -pme) dapat dibaca di laman Getting good performance from mdrun — GROMACS 2021.1 documentation dan Creating Faster Molecular Dynamics Simulations with GROMACS 2020 | NVIDIA Developer Blog.

Berikut adalah contoh SLURM script dengan penggunaan 1 GPU.

#!/bin/bash

#SBATCH --partition=gpu_ampere # Menggunakan Compute Node GPU.

#SBATCH --ntasks=32 # Contoh menggunakan 32 core CPU ...

#SBATCH --gres=gpu:1 # dengan 1 GPU.

#SBATCH --mem=48GB # Contoh menggunakan RAM 48GB.

#SBATCH --time=10:00:00 # Contoh menetapkan walltime maks 10 jam.

#SBATCH --output=result-%j.out # Output terminal program.

#SBATCH --error=result-%j.err # Output verbose program.

# Memuat modul GROMACS

module load gromacs

# RUN COMMAND

# Definisikan jumlah thread OpenMP menyesuaikan ntasks

export OMP_NUM_THREADS=${SLURM_NTASKS}

gmx_mpi mdrun <parameter_input_dan_output>

Akselerasi Banyak GPU di GPU Node dan Hybrid MPI/OMP

User dapat menggunakan lebih dari satu GPU dengan paralelisme hybrid MPI dan OpenMP. Terdapat beberapa aturan untuk menjalankan GROMACS dengan lebih dari satu GPU:

- Pada jumlah proses MPI, EFISON merekomendasikan (atau sangat menganjurkan) untuk disamakan dengan jumlah GPU yang dipakai, sehingga:

Jumlah proses MPI = jumlah GPU yang digunakan

- Berikutnya user memilih jumlah thread OMP per MPI. Jumlah thread OMP maksimal adalah 6 thread OMP per MPI.

- Jumlah core CPU yang dipakai (ntasks) pada script SLURM mengikuti perumusan:

ntasks = jumlah GPU yang dipakai * jumlah thread OMP per MPI yang dipilih user

Berikut adalah contoh SLURM script dengan penggunaan 2 GPU dimana user memilih untuk menggunakan 4 thread OMP per MPI.

#!/bin/bash

#SBATCH --partition=gpu_ampere # Menggunakan Compute Node GPU.

#SBATCH --ntasks=8 # Pada contoh ini, user menggunakan 4 thread OMP per MPI ...

# sehingga ntasks = 2 GPU * 4 OMP = 8

#SBATCH --gres=gpu:2 # Menggunakan 2 GPU.

#SBATCH --mem=48GB # Contoh menggunakan RAM 48GB.

#SBATCH --time=10:00:00 # Contoh menetapkan walltime maks 10 jam.

#SBATCH --output=result-%j.out # Output terminal program.

#SBATCH --error=result-%j.err # Output verbose program.

# Memuat modul GROMACS

module load gromacs

# Set nilai OMP

export OMP_NUM_THREADS=4

# PERINTAH SPESIFIK UNTUK OPENMPI DI PARTITION gpu_ampere

# Tanpa unset, proses MPI tidak akan berjalan di partition gpu_ampere

unset UCX_TLS

unset UCX_NET_DEVICES

# RUN COMMAND

# Jumlah mpirun = jumlah GPU yang dipakai

mpirun -np 2 --mca pml ucx --mca osc ucx gmx_mpi mdrun <parameter_input_dan_output>