GROMACS: Perbedaan antara revisi

WilsonLisan (bicara | kontrib) (major paraphrasing) |

WilsonLisan (bicara | kontrib) (→Pilihan Menjalankan Komputasi: menambah info partisi ampere) |

||

| (68 revisi perantara oleh pengguna yang sama tidak ditampilkan) | |||

| Baris 1: | Baris 1: | ||

== ''' | [[Berkas:Logo GROMACS ALELEON tp.png|nirbing|500x500px]] | ||

'''[[https://www.gromacs.org/ GROMACS]]''' adalah package berkecepatan tinggi untuk komputasi dinamika molekular baik untuk biokimia (seperti protein, lipids) maupun non-biokimia (seperti polimer). | |||

== '''''Modul GROMACS''''' == | |||

Berikut adalah detail versi GROMACS yang tersedia secara global di ALELEON Supercomputer: | |||

* Hubungi tim admin melalui email '''support@efisonlt.com''' untuk permintaan instalasi versi lain. | |||

{| class="wikitable" | {| class="wikitable" | ||

!Versi | |+Modul GROMACS | ||

!Nama | ! rowspan="3" | Versi | ||

!Dukungan | ! rowspan="3" |Nama modul | ||

! | ! colspan="5" |Dukungan hardware | ||

! | |- | ||

! rowspan="2" |[[Berkas:GMB CPU icon.png|nirbing|50x50px]] | |||

! rowspan="2" |[[Berkas:GMB GPU icon.png|nirbing|80x80px]] | |||

! colspan="3" |Parallel run | |||

|- | |||

!OMP<sup>''1''</sup> | |||

!MPI<sup>''2''</sup> | |||

!Hybrid''<sup>3</sup>'' | |||

|- | |- | ||

|2021.1 | |2021.1 | ||

|gromacs | |<code>'''gromacs/2021.1-GCC10-MKL'''</code> | ||

| | !V | ||

!- | |||

| | !- | ||

!V | |||

!- | |||

|- | |||

|2022.4 | |||

|<code>'''gromacs/2022.4-GCC11.3-AOCL4.0-CUDA11.8'''</code> | |||

!V | |||

!V | |||

! V | |||

!V | |||

!V (GPU) | |||

|- | |||

|2024.4 | |||

|<code>'''gromacs/2024.4-GCC12.3-AOCL5.0-CUDA12.5'''</code> | |||

!V | |||

!V | |||

!V | |||

!V | |||

!V (GPU) | |||

|} | |||

'''Note:''' | |||

#'''OMP''' -> komputasi berjalan multi-core CPU melalui API OpenMP. | |||

#'''MPI''' -> komputasi berjalan multi-core CPU dan multi-node melalui protokol MPI (Message Passing Interface). | |||

#'''Hybrid''' -> komputasi berjalan multi-core CPU dan multi-node melalui kombinasi OpenMP dan MPI. | |||

== '''''Info Menjalankan GROMACS dengan Akselerasi GPU''''' == | |||

ALELEON Supercomputer menyediakan GROMACS yang dapat berjalan dengan akselerasi GPU. Beberapa hal perlu menjadi pertimbangan user: | |||

* Akselerasi GPU bukan jaminan peningkatan performa pada semua jenis input dan parameter. | |||

** Tim admin menyarankan user untuk menguji hal ini di perangkat komputer pribadi. | |||

* Biasanya GROMACS mdrun tidak memerlukan parameter tambahan untuk akselerasi GPU. | |||

** Dalam beberapa kasus, optimasi parameter tambahan dapat meningkatkan kecepatan komputasi. | |||

* Referensi lanjutan parameter akselerasi GPU (-nb, -bonded, -pme) dapat dipelajari pada tautan berikut: | |||

** '''[[https://manual.gromacs.org/current/user-guide/mdrun-performance.html Getting good performance from mdrun — GROMACS 2021.1 documentation]]''' | |||

** '''[[https://developer.nvidia.com/blog/creating-faster-molecular-dynamics-simulations-with-gromacs-2020 Creating Faster Molecular Dynamics Simulations with GROMACS 2020 | NVIDIA Developer Blog]]''' | |||

=='''''Pilihan Menjalankan Komputasi'''''== | |||

Berikut opsi menjalankan GROMACS, pilih sesuai kebutuhan: | |||

{| class="wikitable" | |||

!Jenis Komputasi | |||

!Berjalan di | |||

|- | |||

|'''<big>[[https://wiki.efisonlt.com/wiki/GROMACS#Batch_Job Batch Job]]</big>''' | |||

*Menjalankan komputasi siap jalan melalui manajemen Slurm. | |||

|'''[<nowiki/>[[Spesifikasi ALELEON Supercomputer#Spesifikasi%20Compute%20Node|Compute node]]]:''' | |||

* Partisi epyc [[Berkas:GMB CPU icon.png|nirbing|50x50px]] | |||

* Partisi ampere [[Berkas:GMB GPU icon.png|nirbing|70x70px]] | |||

|} | |} | ||

===Batch Job=== | |||

Tersedia dua pilihan tampilan yaitu terminal dan web EFIRO melalui app Job Composer. Pilih sesuai keinginan. | |||

''<small><code>(klik expand / kembangkan)</code></small>'' | |||

{| class="wikitable mw-collapsible mw-collapsed" | |||

!- Langkah Batch Job di Terminal - | |||

[[Berkas:Sbatch terminal display rev2.png|tepi|400x400px]] | |||

|- | |||

!''Tutorial ini mengasumsikan user familiar dengan terminal Linux'' | |||

|- | |||

|[[Berkas:EOD Apps Shell full.png|kiri|nirbing|101x101px]]'''''Menggunakan terminal!''''' | |||

*''User EFIRO klik app '''<code>Aleleon Shell Access</code>''''' | |||

*''atau menu '''<code>Apps > Aleleon Shell Access</code>''''' | |||

|- | |||

!<big>0</big> | |||

|- | |||

!Apakah bisa menjalankan job? | |||

|- | |||

|User dengan '''Kredit Core Hour''' disarankan cek kuota terlebih dulu: | |||

$ '''sausage''' | |||

*'''''Untuk akun institusi ikuti petunjuk support EFISON.''''' | |||

*Detail limit alokasi komputasi job lihat langkah '''<big>2B</big>'''. | |||

*Bila butuh tambah kuota, lihat '''[[https://wiki.efisonlt.com/wiki/Core_Hour#Penggunaan_Kredit_Core_Hour top up Kredit Core Hour]]''' | |||

|- | |||

!<big>1</big> | |||

|- | |||

!Lakukan persiapan: | |||

|- | |||

| | |||

* Siapkan file komputasi yang dibutuhkan: | |||

**Upload / download file lihat '''[[https://wiki.efisonlt.com/wiki/Manajemen_File_di_ALELEON_Supercomputer#Upload_dan_Download_File Upload / Dow]<nowiki/>[https://wiki.efisonlt.com/wiki/Manajemen_File_di_ALELEON_Supercomputer#Upload_dan_Download_File nload File HOME]]''' | |||

*Pre-processing input dan parameter GROMACS'''<nowiki/>''' lihat subbab: | |||

** '''[[https://wiki.efisonlt.com/wiki/GROMACS#Pre-processing_Input_dan_Parameter Pre-processing Input dan Parameter]]''' '''<nowiki/>''' | |||

|- | |||

!<big>2A</big> | |||

|- | |||

|Buat '''Submit Script''' yaitu 'formulir' untuk menjalankan job komputasi: | |||

*Nama file bebas dengan format .sh, contoh '''<code>submit.sh</code>''' | |||

*''Biasanya submit script berada satu folder dengan file komputasi.'' | |||

$ '''nano submit.sh''' | |||

''<small>atau vim</small>'' | |||

|- | |||

! | |||

|- | |||

|Contoh template Submit Script: | |||

* Ikuti petunjuk '''NOTES dan alur script''' di dalamnya. | |||

''<small><code>Klik expand / kembangkan</code></small>'' | |||

{| class="wikitable mw-collapsible mw-collapsed" | |||

!- Template Submit Script GROMACS versi CPU - | |||

[[Berkas:GMB CPU icon.png|nirbing|80x80px]] | |||

|- | |||

|<syntaxhighlight lang="bash" line="1"> | |||

#!/bin/bash | |||

# ----------------------------------------------------- | |||

# Template SLURM Submit Script | |||

# GROMACS (versi CPU) | rev.201224 | |||

# | |||

# NOTES: | |||

# 1. Isi bagian yang ditandai 4 garing (////). | |||

# 2. Template ini bersifat referensi. | |||

# User dapat mengubah bagian yang perlu diubah. | |||

# ----------------------------------------------------- | |||

# ----------------------------------------------------- | |||

# Alokasi komputasi SBATCH dan file input | |||

# ----------------------------------------------------- | |||

# Alokasi jumlah core thread CPU | |||

#SBATCH --ntasks=//// | |||

# Alokasi jumlah memori RAM (satuan GB) | |||

#SBATCH --mem=////GB | |||

# Alokasi limit waktu menjalankan job | |||

# Format HH:MM:SS atau D-HH:MM:SS | |||

#SBATCH --time=//// | |||

# Definisi file untuk menampung output terminal program | |||

#SBATCH --output=result-%j.txt | |||

= | # Definisi file untuk menampung output error log | ||

#SBATCH --error=error-%j.txt | |||

# Parameter input dan output untuk gmx_mpi mdrun | |||

GROMACS_PARAMETER="////" | |||

# ---------------------------------------------------- | |||

# Script jalannya program | |||

# ---------------------------------------------------- | |||

# Memuat modul software GROMACS | |||

# Daftar modul lihat subbab "Modul GROMACS" di atas | |||

module load gromacs//// | |||

# Perintah menjakankan GROMACS | |||

mpirun -np ${SLURM_NTASKS} gmx_mpi mdrun ${GROMACS_PARAMETER} | |||

</syntaxhighlight> | |||

|} | |||

{| class="wikitable mw-collapsible mw-collapsed" | |||

!- Template Submit Script GROMACS versi GPU - | |||

[[Berkas:GMB GPU icon.png|nirbing|100x100px]] | |||

|- | |||

|[[Berkas:GMB warning wololo.png|nirbing|50x50px]] '''Note:''' | |||

* GROMACS versi GPU menggunakan '''threading OMP per task MPI:''' | |||

** '''Task MPI''' diwakili oleh '''jumlah GPU (<code>SBATCH gpus</code>)''' | |||

** '''Thread OMP''' diwakili oleh '''<code>SBATCH cpus-per-task</code>''' | |||

** Perhatikan '''total CPU''' = ntasks * cpus-per-task | |||

* Jumlah thread OMP disarankan '''2 atau 4.''' | |||

|- | |||

|<syntaxhighlight lang="bash" line="1"> | |||

#!/bin/bash | |||

# -------------------------------------------------------- | |||

# Template SLURM Submit Script | |||

# GROMACS (versi GPU) | rev.201224 | |||

# | |||

# NOTES: | |||

# 1. Isi bagian yang ditandai 4 garing (////). | |||

# 2. Template ini bersifat referensi. | |||

# User dapat mengubah bagian yang perlu diubah. | |||

# 3. GROMACS GPU menggunakan threading OMP per task MPI | |||

# Perhatikan usage CPU = ntasks * cpus-per-task | |||

# -------------------------------------------------------- | |||

# ----------------------------------------------------- | |||

# Alokasi komputasi SBATCH dan file input | |||

# ----------------------------------------------------- | |||

# Menggunakan partisi compute node GPU | |||

#SBATCH --partition=ampere | |||

# Alokasi jumlah core thread CPU | |||

#SBATCH --ntasks=//// | |||

# Alokasi jumlah GPU, menjadi jumlah task MPI | |||

#SBATCH --gpus=//// | |||

# Alokasi jumlah thread OMP per task MPI | |||

# Disarankan 2 atau 4 | |||

#SBATCH --cpus-per-task=//// | |||

# Alokasi jumlah memori RAM (satuan GB) | |||

#SBATCH --mem=////GB | |||

# Alokasi limit waktu menjalankan job | |||

# Format HH:MM:SS atau D-HH:MM:SS | |||

#SBATCH --time=//// | |||

# Definisi file untuk menampung output terminal program | |||

#SBATCH --output=result-%j.txt | |||

# Definisi file untuk menampung output error log | |||

#SBATCH --error=error-%j.txt | |||

# Parameter input dan output untuk gmx_mpi mdrun | |||

GROMACS_PARAMETER="////" | |||

# ---------------------------------------------------- | |||

# Script jalannya program | |||

# ---------------------------------------------------- | |||

# Memuat modul software GROMACS yang dapat menggunakan GPU | |||

# Daftar modul lihat subbab "Modul GROMACS" di atas | |||

module load gromacs//// | |||

# Threading OMP | |||

export OMP_NUM_THREADS=${SLURM_CPUS_PER_TASK} | |||

# Perintah menjalankan GROMACS 1 GPU dan multiple GPU | |||

if [ $SLURM_GPUS -eq 1 ] | |||

then | |||

echo "Terdeteksi running GROMACS dengan 1 GPU" | |||

gmx_mpi mdrun ${GROMACS_PARAMETER} | |||

elif [ $SLURM_GPUS -gt 1 ] | |||

then | |||

echo "Terdeteksi running GROMACS dengan $SLURM_GPUS GPU" | |||

# Unset UCX supaya MPI berjalan di NVIDIA | |||

unset UCX_TLS | |||

unset UCX_NET_DEVICES | |||

mpirun -np $SLURM_GPUS gmx_mpi mdrun ${GROMACS_PARAMETER} | |||

fi | |||

</syntaxhighlight> | |||

|} | |||

|- | |||

! | |||

|- | |||

| | |||

* ''Detail Submit Script lihat '''[<nowiki/>[[Submit Script ALELEON Supercomputer|Subm]][[Submit Script ALELEON Supercomputer|it Script ALELEON Supercomputer]]]''''' | |||

*''Untuk SBATCH notifikasi email status jalannya job lihat '''[[https://wiki.efisonlt.com/wiki/Submit_Script_ALELEON_Supercomputer#SBATCH_untuk_notifikasi_email_SLURM Slurm Jojo]]''''' | |||

*''Detail menjalankan program MPI lihat '''[<nowiki/>[[MPI ALELEON Supercomputer]]]''''' | |||

|- | |||

!<big>2B</big> | |||

|- | |||

!Berapa alokasi komputasi yang bisa digunakan? | |||

|- | |||

|SBATCH komputasi (ntasks, mem, time, dll) '''punya limit''' berdasarkan: | |||

*Sisa Core Hour user dan '''[<nowiki/>[[Limitasi Fair Usage ALELEON Supercomputer|Fair Usage Limit]]]''' | |||

*Spesifikasi sistem dan software komputasi. | |||

Untuk melihat limit, jalankan perintah berikut: | |||

$ '''slimit-gromacs''' | |||

[[Berkas:GMB warning wololo.png|nirbing|50x50px]] '''Note untuk saat ini:''' | |||

*''Jalankan ketika tidak ada job user yang berjalan atau antri.'' | |||

* ''Sementara berlaku untuk akun perseorangan saja.'' | |||

|- | |||

!<big>3</big> | |||

|- | |||

| Jalankan job dengan perintah: | |||

$ '''sbatch ''[nama-submit-script]''''' | |||

''Contoh:'' | |||

$ sbatch submit.sh | |||

|- | |||

!<big>4</big> | |||

|- | |||

| User dapat melihat status jalannya job dengan perintah: | |||

$ '''squeue -ul $USER''' | |||

*''Apabila tidak ada di squeue artinya job bersangkutan telah berakhir.'' | |||

*''Waktu jalan job bergantung pada software komputasi itu sendiri.'' | |||

*''Apabila komputasi selesai sebelum limit waktu maka job juga selesai.'' | |||

{| class="wikitable" | |||

|+Kolom ST atau STATE menunjukkan status jalannya job: | |||

|- | |||

!STATE | |||

!Penjelasan | |||

|- | |||

|<code>'''R (RUN)'''</code> | |||

|Job berjalan | |||

|- | |||

|<code>'''PD (PENDING)'''</code> | |||

|Job tertahan, lihat '''[<nowiki/>[[Daftar Job Reason ALELEON Supercomputer|Daftar Job Reason]]]''' | |||

|- | |||

|<code>'''CG (COMPLETING)'''</code> | |||

|Job selesai dan dalam proses clean-up | |||

|- | |||

|<code>'''CA (CANCELED)'''</code> | |||

|Job dibatalkan user | |||

|- | |||

|<code>'''PR (PREEMPETED)'''</code> | |||

| Job dibatalkan admin, alasan dikabarkan via email | |||

|- | |||

|<code>'''S (SUSPENDED)'''</code> | |||

| Job ditahan admin, alasan dikabarkan via email | |||

|} | |||

|- | |||

!<big>5</big> | |||

|- | |||

|User dapat memantau file output dengan perintah Unix seperti: | |||

*'''<code>ls</code>''', '''<code>cat</code>''', '''<code>more</code>''', '''<code>tail</code>''', dll | |||

|- | |||

!<big>6</big> | |||

|- | |||

| Apabila user ingin menghentikan job yang berjalan, jalankan perintah: | |||

$ '''scancel ''[job-ID]''''' | |||

# | ''Job ID ada pada squeue diatas.'' | ||

# | contoh membatalkan job ID 231: | ||

$ '''scancel 231''' | |||

|- | |||

!--- | |||

|} | |||

{| class="wikitable mw-collapsible mw-collapsed" | |||

!- Langkah Batch Job di EFIRO Job Composer - | |||

[[Berkas:Efiro jobcomposer display.png|nirbing|400x400px]] | |||

|- | |||

!<big>0</big> | |||

|- | |||

!Apakah bisa menjalankan job? | |||

|- | |||

|User dengan '''Kredit Core Hour''' disarankan cek kuota terlebih dulu: | |||

#Buka menu '''<big><code>Apps > Aleleon Shell Access</code></big>''' | |||

#Jalankan: | |||

$ '''sausage''' | |||

*'''''Untuk akun institusi ikuti petunjuk support EFISON.''''' | |||

*Detail limit alokasi komputasi job lihat langkah '''<big>5B</big>'''. | |||

*Bila butuh tambah kuota, lihat '''[[https://wiki.efisonlt.com/wiki/Core_Hour#Penggunaan_Kredit_Core_Hour top up Kredit Core Hour]]''' | |||

|- | |||

!<big>1</big> | |||

|- | |||

| Lakukan [https: / wiki.efisonlt.com wiki Menggunakan_ALELEON_Supercomputer_via_Terminal#1_ |'''[[https://wiki.efisonlt.com/wiki/Menggunakan_ALELEON_Supercomputer_via_EFIRO#Login_Web_EFIRO Login ke web EFIRO]]''' ALELEON Supercomputer. | |||

|- | |||

! <big>2</big> | |||

|- | |||

| | |||

{| class="wikitable" | |||

|+ | |||

|[[Berkas:EOD Apps Job Composer full.png|nirbing|126x126px]] | |||

|Klik app '''<code><big>Job Composer</big></code>''' di homepage EFIRO. | |||

*''atau'' menu '''<big><code>Apps > Job Composer</code></big>''' | |||

|} | |||

|- | |||

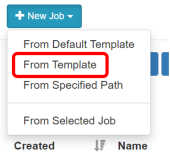

|[[Berkas:Jcnewjobmarked.png|nirbing|170x170px]]Pilih menu <big>'''<code>New Job > From Template</code>'''</big> | |||

|- | |||

!<big>3</big> | |||

|- | |||

!Buat ruang job untuk menjalankan komputasi: | |||

|- | |||

| | |||

{| class="wikitable" | |||

|+Pillih template GROMACS yang diinginkan: | |||

|- | |||

!Nama Template | |||

!Penjelasan | |||

|- | |||

|GROMACS 2021.1 (CPU) | |||

|Menjalankan GROMACS 2021.1 pada CPU | |||

|- | |||

|GROMACS 2022.4 (CPU) | |||

|Menjalankan GROMACS 2022.4 pada CPU | |||

|- | |||

|GROMACS 2022.4 (GPU) | |||

|Menjalankan GROMACS 2022.4 pada GPU | |||

|- | |||

|GROMACS 2024.4 (CPU) | |||

|Menjalankan GROMACS 2022.4 pada CPU | |||

|- | |||

|GROMACS 2024.4 (GPU) | |||

|Menjalankan GROMACS 2022.4 pada GPU | |||

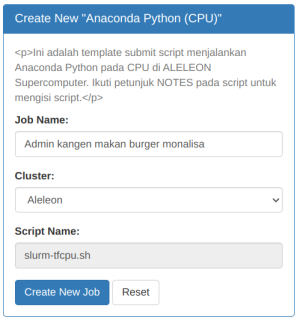

|}Kemudian isi '''Job Name''' dan klik '''<code><big>Create New Job</big></code>''' | |||

[[Berkas:Jctemplate-2.png|nirbing]] | |||

|- | |||

!<big>4</big> | |||

|- | |||

!Lakukan persiapan: | |||

|- | |||

|Siapkan file komputasi yang dibutuhkan di ruang job: | |||

*''Pastikan ruang job yang dipilih adalah yang akan digunakan.'' | |||

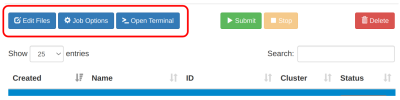

* Upload / download / edit file via menu <code>'''<big>Edit Files</big>'''</code> | |||

*Upload / download file tunggal diatas 2GB gunakan '''[[https://wiki.efisonlt.com/wiki/Manajemen_File_di_ALELEON_Supercomputer#Upload_/_Download_Ruang_Job_Composer software FTP]]''' | |||

Pre-processing input dan parameter via menu '''<code><big>Open Terminal</big></code>''' | |||

*Lihat subbab '''[[https://wiki.efisonlt.com/wiki/GROMACS#Pre-processing_Input_dan_Parameter Pre-processing Input dan Par]<nowiki/>[https://wiki.efisonlt.com/wiki/GROMACS#Pre-processing_Input_dan_Parameter ameter]]''' | |||

[[Berkas:JC job menu.png|nirbing|400x400px]] | |||

|- | |||

!<big>5A</big> | |||

|- | |||

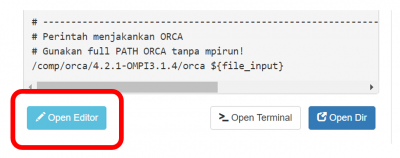

| Lengkapi '''Submit Script''' melalui tombol '''<code><big>Open Editor</big></code>''' | |||

*Submit script adalah 'formulir' untuk menjalankan job komputasi. | |||

*Ikuti petunjuk '''NOTES dan alur script''' di dalamnya. | |||

* Klik '''<code><big>Save</big></code>''' setiap kali mengubah script. | |||

[[Berkas:Jceditor3.png|al=|nirbing|400x400px]] | |||

|- | |||

|[[Berkas:GMB warning wololo.png|nirbing|50x50px]] '''Bagi yang memilih template GROMACS versi GPU:''' | |||

*GROMACS versi GPU menggunakan '''threading OMP per task MPI:''' | |||

** '''Task MPI''' diwakili oleh '''jumlah GPU (<code>SBATCH gpus</code>)''' | |||

** '''Thread OMP''' diwakili oleh '''<code>SBATCH cpus-per-task</code>''' | |||

** Perhatikan '''total CPU''' = ntasks * cpus-per-task | |||

* Jumlah thread OMP disarankan '''2 atau 4.''' | |||

|- | |||

! | |||

|- | |||

| | |||

* ''Detail Submit Script lihat '''[<nowiki/>[[Submit Script ALELEON Supercomputer|Subm]][[Submit Script ALELEON Supercomputer|it Script ALELEON Supercomputer]]]''''' | |||

*''Untuk SBATCH notifikasi email status jalannya job lihat '''[[https://wiki.efisonlt.com/wiki/Submit_Script_ALELEON_Supercomputer#SBATCH_untuk_notifikasi_email_SLURM Slurm Jojo]]''''' | |||

*''Detail menjalankan program MPI lihat '''[<nowiki/>[[MPI ALELEON Supercomputer]]]''''' | |||

|- | |||

!<big>5B</big> | |||

|- | |||

| SBATCH komputasi (ntasks, mem, time, dll) '''punya limit''' berdasarkan: | |||

*Sisa Core Hour user dan '''[<nowiki/>[[Limitasi Fair Usage ALELEON Supercomputer|Fair Usage Limit]]]''' | |||

*Spesifikasi sistem dan software komputasi. | |||

Untuk melihat limit, jalankan perintah berikut: | |||

$ '''slimit-gromacs''' | |||

[[Berkas:GMB warning wololo.png|nirbing|50x50px]] '''Note untuk saat ini:''' | |||

*''Jalankan ketika tidak ada job user yang berjalan atau antri.'' | |||

* ''Sementara berlaku untuk akun perseorangan saja.'' | |||

|- | |||

!<big>6</big> | |||

|- | |||

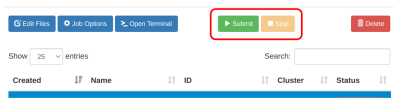

|Jalankan job dengan klik tombol '''<code><big>Submit</big></code>''' | |||

[[Berkas:JC job runstop.png|al=|nirbing|400x400px]] | |||

*''Waktu jalan job bergantung pada software komputasi itu sendiri.'' | |||

*''Apabila komputasi selesai sebelum limit waktu maka job juga selesai.'' | |||

{| class="wikitable" | |||

|+Kolom Status menunjukkan status jalannya job: | |||

|- | |||

!Status | |||

!Arti | |||

|- | |||

|'''Not Submitted''' | |||

|Job belum pernah dijalankan. | |||

|- | |||

|'''Running''' | |||

|Job berjalan. | |||

|- | |||

|'''Queue''' | |||

|Job mengantri dan belum berjalan. | |||

|- | |||

|'''Completed''' | |||

|Job selesai berjalan. | |||

|- | |||

|'''Failed''' | |||

|Job berhenti karena error atau di stop user. | |||

|- | |||

! colspan="2" |'''Melihat alasan job yang queue:''' | |||

|- | |||

| colspan="2" | [[Berkas:Active Jobs detail.png|nir|jmpl|300x300px|''Buka menu '''Apps >''' '''Active Jobs''' di homepage EFIRO. Ubah opsi All jobs ke '''Your Jobs'''. Klik simbol '''>''' untuk melihat status job yang pending pada kolom Reason. Arti reason lihat laman '''[[Daftar Job Reason ALELEON Supercomputer]]''''']] | |||

|} | |||

|- | |||

!<big>7</big> | |||

|- | |||

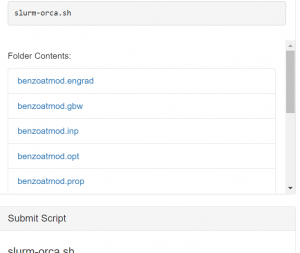

|Lihat output file komputasi pada kolom '''Folder Contents''' | |||

*Atau dengan membuka menu '''<code><big>Edit Files</big></code>''' | |||

[[Berkas:Jcfoldercontentsedit.png|al=|nir|jmpl|''Kolom '''<code>Folder Contents</code>''''']] | |||

|- | |||

!<big>8</big> | |||

|- | |||

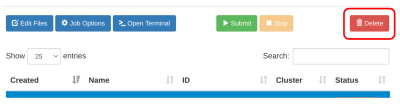

|Apabila user ingin menghentikan job yang berjalan, klik '''<code><big>Stop</big></code>''' | |||

|- | |||

!<big>9</big> | |||

|- | |||

|'''''<nowiki/>'''''Untuk menghapus ruang job dan datanya: | |||

* Pilih ruang job yang akan dihapus. | |||

* Perhatikan opsi ini juga '''menghapus data di ruang job tersebut.''' | |||

*Klik menu '''<code><big>Delete</big></code>''' | |||

[[Berkas:JC delete menu.png|nirbing|400x400px]] | |||

|- | |||

!--- | |||

|} | |||

== | == '''''Pre-processing''' '''Input dan Parameter''''' == | ||

GROMACS membutuhkan pengolahan file input dan parameter sebelum menjalankan komputasi. | |||

* ''Kegiatan ini dilakukan di login node sehingga tidak mengkonsumsi Kredit Core Hour.'' | |||

* ''Hubungi tim admin apabila user membutuhkan panduan atau tambahan software package tertentu.'' | |||

ALELEON Supercomputer menyediakan variasi berikut: | |||

# '''[[https://wiki.efisonlt.com/wiki/GROMACS#gmx_mpi gmx_mpi]]''' | |||

# '''[[https://wiki.efisonlt.com/wiki/GROMACS#ACPYPE_(AnteChamber_PYthon_Parser_InterfacE) ACPYPE]]''' | |||

=== ''' | === gmx_mpi === | ||

User | GROMACS ALELEON Supercomputer diinstal dengan dukungan MPI sehingga user menggunakan <code>'''gmx_mpi'''</code>, bukan <code>'''gmx'''</code>. | ||

{| class="wikitable" | |||

!Menjalankan gmx_mpi | |||

|- | |||

!<big>0</big> | |||

|- | |||

|[[Berkas:Icon apps terminal cropped.png|kiri|nirbing|80x80px]]'''Menggunakan terminal!''' | |||

*User Job Composer buka menu '''<code><big>Open Terminal</big></code>''' di ruang job-nya | |||

|- | |||

!<big>1</big> | |||

|- | |||

|Aktifkan modul GROMACS yang akan dipakai. | |||

$ '''ml ''[nama-modul-GROMACS]''''' | |||

''Nama modul lihat subbab 'Modul GROMACS' diatas.'' | |||

|- | |||

!<big>2</big> | |||

|- | |||

|Gunakan perintah '''<code>gmx_mpi</code>''' untuk pre-processing input. | |||

Contoh dengan pdb2gmx: | |||

$ gmx_mpi pdb2gmx ''[parameter-input-output]'' | |||

|- | |||

!--- | |||

|} | |||

''Kembali ke subbab '''[[https://wiki.efisonlt.com/wiki/GROMACS#Batch_Job Batch Job]]''''' | |||

* ''' | === ACPYPE (AnteChamber PYthon Parser InterfacE) === | ||

ACPYPE adalah wrapper Python berdasarkan software ANTECHAMBER untuk membantu pengolahan file input dan parameter software MD (Molecular Dynamic) seperti GROMACS ini. | |||

{| class="wikitable" | |||

!- Menggunakan container ACPYPE - | |||

|- | |||

!<big>0</big> | |||

|- | |||

|[[Berkas:Icon apps terminal cropped.png|kiri|nirbing|80x80px]]'''Menggunakan terminal!''' | |||

*User Job Composer buka menu '''<code><big>Open Terminal</big></code>''' di ruang job-nya | |||

|- | |||

!<big>1</big> | |||

|- | |||

|Aktifkan container Apptainer: | |||

$ '''ml apptainer''' | |||

|- | |||

!<big>2</big> | |||

|- | |||

|Aktifkan container ACPYPE, tersedia versi 2023.10.27: | |||

$ '''apptainer run $SCONT/acpype-2023.10.27.sif''' | |||

Kemudian user dapat menggunakan ACPYPE: | |||

Apptainer> '''''[jalankan perintah ACPYPE ...]''''' | |||

|- | |||

!<big>3</big> | |||

|- | |||

|Untuk keluar dari container, jalankan perintah: | |||

Apptainer> '''exit''' | |||

|- | |||

!--- | |||

|} | |||

''Kembali ke subbab '''[[https://wiki.efisonlt.com/wiki/GROMACS#Batch_Job Batch Job]]''''' | |||

=='''''Pelaporan Kendala dan Support''''' == | |||

Apabila menjumpai masalah teknis dalam menjalankan komputasi, silahkan lapor dengan klik gambar berikut ini. | |||

[[Berkas:Wiki-pelaporankendala.jpg|1000x1000px|link=https://efisonlt.com/aleleonbugreport]] | |||

Bila terdapat pertanyaan lainnya, silahkan hubungi admin EFISON melalui email: | |||

'''support@efisonlt.com''' | |||

''' | |||

Revisi terkini sejak 11 Mei 2025 11.42

[GROMACS] adalah package berkecepatan tinggi untuk komputasi dinamika molekular baik untuk biokimia (seperti protein, lipids) maupun non-biokimia (seperti polimer).

Modul GROMACS

Berikut adalah detail versi GROMACS yang tersedia secara global di ALELEON Supercomputer:

- Hubungi tim admin melalui email support@efisonlt.com untuk permintaan instalasi versi lain.

Note:

- OMP -> komputasi berjalan multi-core CPU melalui API OpenMP.

- MPI -> komputasi berjalan multi-core CPU dan multi-node melalui protokol MPI (Message Passing Interface).

- Hybrid -> komputasi berjalan multi-core CPU dan multi-node melalui kombinasi OpenMP dan MPI.

Info Menjalankan GROMACS dengan Akselerasi GPU

ALELEON Supercomputer menyediakan GROMACS yang dapat berjalan dengan akselerasi GPU. Beberapa hal perlu menjadi pertimbangan user:

- Akselerasi GPU bukan jaminan peningkatan performa pada semua jenis input dan parameter.

- Tim admin menyarankan user untuk menguji hal ini di perangkat komputer pribadi.

- Biasanya GROMACS mdrun tidak memerlukan parameter tambahan untuk akselerasi GPU.

- Dalam beberapa kasus, optimasi parameter tambahan dapat meningkatkan kecepatan komputasi.

- Referensi lanjutan parameter akselerasi GPU (-nb, -bonded, -pme) dapat dipelajari pada tautan berikut:

Pilihan Menjalankan Komputasi

Berikut opsi menjalankan GROMACS, pilih sesuai kebutuhan:

| Jenis Komputasi | Berjalan di |

|---|---|

[Batch Job]

|

[Compute node]: |

Batch Job

Tersedia dua pilihan tampilan yaitu terminal dan web EFIRO melalui app Job Composer. Pilih sesuai keinginan.

(klik expand / kembangkan)

| - Langkah Batch Job di Terminal - | ||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Tutorial ini mengasumsikan user familiar dengan terminal Linux | ||||||||||||||

Menggunakan terminal!

| ||||||||||||||

| 0 | ||||||||||||||

| Apakah bisa menjalankan job? | ||||||||||||||

User dengan Kredit Core Hour disarankan cek kuota terlebih dulu:

$ sausage

| ||||||||||||||

| 1 | ||||||||||||||

| Lakukan persiapan: | ||||||||||||||

| ||||||||||||||

| 2A | ||||||||||||||

Buat Submit Script yaitu 'formulir' untuk menjalankan job komputasi:

$ nano submit.sh atau vim | ||||||||||||||

Contoh template Submit Script:

| ||||||||||||||

| ||||||||||||||

| 2B | ||||||||||||||

| Berapa alokasi komputasi yang bisa digunakan? | ||||||||||||||

SBATCH komputasi (ntasks, mem, time, dll) punya limit berdasarkan:

Untuk melihat limit, jalankan perintah berikut: $ slimit-gromacs

| ||||||||||||||

| 3 | ||||||||||||||

Jalankan job dengan perintah:

$ sbatch [nama-submit-script] Contoh: $ sbatch submit.sh | ||||||||||||||

| 4 | ||||||||||||||

User dapat melihat status jalannya job dengan perintah:

$ squeue -ul $USER

| ||||||||||||||

| 5 | ||||||||||||||

User dapat memantau file output dengan perintah Unix seperti:

| ||||||||||||||

| 6 | ||||||||||||||

Apabila user ingin menghentikan job yang berjalan, jalankan perintah:

$ scancel [job-ID] Job ID ada pada squeue diatas. contoh membatalkan job ID 231: $ scancel 231 | ||||||||||||||

| --- |

| - Langkah Batch Job di EFIRO Job Composer - | ||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 0 | ||||||||||||||||

| Apakah bisa menjalankan job? | ||||||||||||||||

User dengan Kredit Core Hour disarankan cek kuota terlebih dulu:

$ sausage

| ||||||||||||||||

| 1 | ||||||||||||||||

| [Login ke web EFIRO] ALELEON Supercomputer. | ||||||||||||||||

| 2 | ||||||||||||||||

| ||||||||||||||||

Pilih menu Pilih menu New Job > From Template

| ||||||||||||||||

| 3 | ||||||||||||||||

| Buat ruang job untuk menjalankan komputasi: | ||||||||||||||||

Create New Job

| ||||||||||||||||

| 4 | ||||||||||||||||

| Lakukan persiapan: | ||||||||||||||||

Siapkan file komputasi yang dibutuhkan di ruang job:

Pre-processing input dan parameter via menu

| ||||||||||||||||

| 5A | ||||||||||||||||

Lengkapi Submit Script melalui tombol Open Editor

| ||||||||||||||||

| ||||||||||||||||

| ||||||||||||||||

| 5B | ||||||||||||||||

SBATCH komputasi (ntasks, mem, time, dll) punya limit berdasarkan:

Untuk melihat limit, jalankan perintah berikut: $ slimit-gromacs

| ||||||||||||||||

| 6 | ||||||||||||||||

Jalankan job dengan klik tombol Submit

| ||||||||||||||||

| 7 | ||||||||||||||||

Lihat output file komputasi pada kolom Folder Contents

| ||||||||||||||||

| 8 | ||||||||||||||||

Apabila user ingin menghentikan job yang berjalan, klik Stop

| ||||||||||||||||

| 9 | ||||||||||||||||

Untuk menghapus ruang job dan datanya:

| ||||||||||||||||

| --- | ||||||||||||||||

Pre-processing Input dan Parameter

GROMACS membutuhkan pengolahan file input dan parameter sebelum menjalankan komputasi.

- Kegiatan ini dilakukan di login node sehingga tidak mengkonsumsi Kredit Core Hour.

- Hubungi tim admin apabila user membutuhkan panduan atau tambahan software package tertentu.

ALELEON Supercomputer menyediakan variasi berikut:

gmx_mpi

GROMACS ALELEON Supercomputer diinstal dengan dukungan MPI sehingga user menggunakan gmx_mpi, bukan gmx.

| Menjalankan gmx_mpi |

|---|

| 0 |

Menggunakan terminal!

|

| 1 |

Aktifkan modul GROMACS yang akan dipakai.

$ ml [nama-modul-GROMACS] Nama modul lihat subbab 'Modul GROMACS' diatas. |

| 2 |

Gunakan perintah gmx_mpi untuk pre-processing input.

Contoh dengan pdb2gmx: $ gmx_mpi pdb2gmx [parameter-input-output] |

| --- |

Kembali ke subbab [Batch Job]

ACPYPE (AnteChamber PYthon Parser InterfacE)

ACPYPE adalah wrapper Python berdasarkan software ANTECHAMBER untuk membantu pengolahan file input dan parameter software MD (Molecular Dynamic) seperti GROMACS ini.

| - Menggunakan container ACPYPE - |

|---|

| 0 |

Menggunakan terminal!

|

| 1 |

Aktifkan container Apptainer:

$ ml apptainer |

| 2 |

Aktifkan container ACPYPE, tersedia versi 2023.10.27:

$ apptainer run $SCONT/acpype-2023.10.27.sif Kemudian user dapat menggunakan ACPYPE: Apptainer> [jalankan perintah ACPYPE ...] |

| 3 |

Untuk keluar dari container, jalankan perintah:

Apptainer> exit |

| --- |

Kembali ke subbab [Batch Job]

Pelaporan Kendala dan Support

Apabila menjumpai masalah teknis dalam menjalankan komputasi, silahkan lapor dengan klik gambar berikut ini.

Bila terdapat pertanyaan lainnya, silahkan hubungi admin EFISON melalui email:

support@efisonlt.com