|

|

| Baris 46: |

Baris 46: |

| |<code>/comp/openmx/3.9.9-GCC11.3-AOCL4.0/DFT_DATA19</code> | | |<code>/comp/openmx/3.9.9-GCC11.3-AOCL4.0/DFT_DATA19</code> |

| |} | | |} |

|

| |

| == '''''Pilihan MPI atau Threading OpenMP untuk Menjalankan OpenMX''''' ==

| |

| OpenMX di ALELEON Supercomputer dapat berjalan melalui paralelisasi '''MPI''', '''OpenMP''' (OMP), atau keduanya ('''hybrid MPI/OMP''') untuk menggunakan multi-core CPU dan multi-node. Admin menyerahkan keputusan kepada user untuk memilih metode paralelisasi melalui parameter Submit Script berikut:

| |

| *'''SBATCH ntasks mewakili jumlah task MPI sedangkan SBATCH cpus-per-task mewakili jumlah thread OMP.'''

| |

| '''#SBATCH --ntasks''' ''-> mewakili jumlah task MPI''

| |

| '''#SBATCH --cpus-per-task''' ''-> mewakili jumlah thread OpenMP''

| |

| *'''Apabila ingin MPI saja <<big>Pure MPI></big>,''' isi jumlah SBATCH cpus-per-task dengan 1:

| |

| ''# Pure MPI''

| |

| '''#SBATCH --ntasks='''''[isi-sesuai-keinginan]''

| |

| '''#SBATCH --cpus-per-task=1'''

| |

| *'''Apabila ingin <big>Hybrid MPI/OMP</big>,''' isi kedua parameter tersebut:

| |

| **'''Total core CPU''' yang digunakan adalah '''ntasks * cpus-per-task'''.

| |

| **Contoh menggunakan 2 proses MPI dan 4 thread OMP per MPI sehingga total menggunakan 8 core CPU:

| |

| ''# Hybrid MPI/OMP, contoh dengan 2 proses MPI dan 4 thread OMP per MPI.''

| |

| '''#SBATCH --ntasks=2'''

| |

| '''#SBATCH --cpus-per-task=4'''

| |

| *'''Apabila ingin OMP saja <<big>Pure OMP</big>>,''' isi jumlah ntasks dengan 1:

| |

| ''# Pure OMP''

| |

| '''#SBATCH --ntasks=1'''

| |

| '''#SBATCH --cpus-per-task='''''[isi-sesuai-keinginan]''

| |

| =='''''Pilihan Menjalankan Komputasi'''''== | | =='''''Pilihan Menjalankan Komputasi'''''== |

| Berikut opsi menjalankan OpenMX, pilih sesuai kebutuhan: | | Berikut opsi menjalankan OpenMX, pilih sesuai kebutuhan: |

Revisi per 11 Mei 2025 12.33

[OpenMX] adalah software package untuk simulasi material skala nano berdasarkan DFT (Density Functional Theories), norm-conserving pseudopotensials, dan pseudo-atomic localized basis functinons. OpenMX merupakan software tidak berbayar dengan lisensi GNU GPLv3.

Modul OpenMX

Berikut adalah detail versi OpenMX yang tersedia secara global di ALELEON Supercomputer:

- Hubungi tim admin melalui email support@efisonlt.com untuk permintaan instalasi versi lain.

Modul OpenMX

| Versi

|

Nama modul

|

Dukungan hardware

|

|

|

Parallel run

|

| OMP1

|

MPI2

|

Hybrid3

|

| 3.9.9

|

openmx/3.9.9-GCC11.3-AOCL4.0

|

V

|

-

|

V

|

V

|

V

|

Note:

- OMP -> komputasi berjalan multi-core CPU melalui API OpenMP.

- MPI -> komputasi berjalan multi-core CPU dan multi-node melalui protokol MPI (Message Passing Interface).

- Hybrid -> komputasi berjalan multi-core CPU dan multi-node melalui kombinasi OpenMP dan MPI.

DATA.PATH pada File Input

User wajib mendefinisikan DATA.PATH berikut pada file input supaya OpenMX dapat berjalan. Daftar DATA.PATH per versi OpenMX lihat tabel di bawah.

DATA.PATH [data-path-OpenMX]

Daftar DATA.PATH OpenMX

| Versi

|

DATA.PATH

|

| 3.9.9

|

/comp/openmx/3.9.9-GCC11.3-AOCL4.0/DFT_DATA19

|

Pilihan Menjalankan Komputasi

Berikut opsi menjalankan OpenMX, pilih sesuai kebutuhan:

| Jenis Komputasi

|

Berjalan di

|

[Batch Job]

- Menjalankan komputasi siap jalan melalui manajemen Slurm.

|

[Compute node]:

- Partisi epyc

|

Batch Job

Tersedia dua pilihan tampilan yaitu terminal dan web EFIRO melalui app Job Composer. Pilih sesuai keinginan.

(klik expand / kembangkan)

| - Langkah Batch Job di Terminal -

|

| Tutorial ini mengasumsikan user familiar dengan terminal Linux

|

Menggunakan terminal!

- User EFIRO klik app

Aleleon Shell Access

- atau menu

Apps > Aleleon Shell Access

|

| 0

|

| Apakah bisa menjalankan job?

|

User dengan Kredit Core Hour disarankan cek kuota terlebih dulu:

$ sausage

- Untuk akun institusi ikuti petunjuk support EFISON.

- Detail limit alokasi komputasi job lihat langkah 2B.

- Bila butuh tambah kuota, lihat [top up Kredit Core Hour]

|

| 1

|

| Lakukan persiapan:

|

*Siapkan file komputasi yang dibutuhkan:**Upload / download file lihat [Upload / Download File HOME]

- Perhatikan [nilai

DATA.PATH] pada file input.

|

| 2A

|

Buat Submit Script yaitu 'formulir' untuk menjalankan job komputasi:

- Nama file bebas dengan format .sh, contoh

submit.sh

- Biasanya submit script berada satu folder dengan file komputasi.

$ nano submit.sh

atau vim

|

|

|

Contoh template Submit Script:

- Ikuti petunjuk NOTES dan alur script di dalamnya.

Klik expand / kembangkan

| - Template Submit Script OpenMX -

|

OpenMX dapat dijalankan dengan opsi paralelisasi: OpenMX dapat dijalankan dengan opsi paralelisasi:

- MPI, OpenMP, atau hybid MPI / OMP.

- Detail lihat subbab [Pilihan MPI atau Threading OpenMP untuk Menjalankan OpenMX]

|

#!/bin/bash

# -----------------------------------------------------

# Template SLURM Submit Script

# OpenMX | rev.080124

#

# NOTES:

# 1. Isi bagian yang ditandai 4 garing (////).

# 2. Template ini bersifat referensi.

# User dapat mengubah bagian yang perlu diubah.

# 3. Perhatikan rate CCH = ntasks * cpus-per-task.

# -----------------------------------------------------

# -----------------------------------------------------

# Alokasi komputasi SBATCH, input, dan module

# -----------------------------------------------------

# Alokasi jumlah core thread CPU, mewakili jumlah task MPI

#SBATCH --ntasks=////

# Alokasi jumlah thread OMP per task MPI

#SBATCH --cpus-per-task=////

# Alokasi jumlah memori RAM (satuan GB)

#SBATCH --mem=////GB

# Alokasi limit waktu menjalankan job

# Format HH:MM:SS atau D-HH:MM:SS

#SBATCH --time=////

# Definisi file untuk menampung output terminal program

#SBATCH --output=result-%j.txt

# Definisi file untuk menampung output error log

#SBATCH --error=error-%j.txt

# Nama input file OpenMX yang dijalankan

INPUT_FILE='////.dat'

# Memuat modul software OpenMX

# Daftar modul lihat subbab "Modul OpenMX" di atas

module load openmx////

# ----------------------------------------------------

# Script jalannya program

# ----------------------------------------------------

# Definisi threading OMP

export OMP_NUM_THREADS=${SLURM_CPUS_PER_TASK}

# Perintah menjakankan OpenMX

mpirun -np ${SLURM_NTASKS} openmx ${INPUT_FILE}

|

|

|

|

|

|

| 2B

|

| Berapa alokasi komputasi yang bisa digunakan?

|

SBATCH komputasi (ntasks, mem, time, dll) punya limit berdasarkan:

- Sisa Core Hour user dan [Fair Usage Limit]

- Spesifikasi sistem dan software komputasi.

Untuk melihat limit, jalankan perintah berikut:

$ slimit-mpi

Note untuk saat ini: Note untuk saat ini:

- Jalankan ketika tidak ada job user yang berjalan atau antri.

- Sementara berlaku untuk akun perseorangan saja.

|

| 3

|

Jalankan job dengan perintah:

$ sbatch [nama-submit-script]

Contoh:

$ sbatch submit.sh

|

| 4

|

User dapat melihat status jalannya job dengan perintah:

$ squeue -ul $USER

- Apabila tidak ada di squeue artinya job bersangkutan telah berakhir.

- Waktu jalan job tidak bergantung oleh alokasi limit waktu di script.

- Job berakhir ketika komputasi selesai atau ada error.

Kolom ST atau STATE menunjukkan status jalannya job:

| STATE

|

Penjelasan

|

R (RUN)

|

Job berjalan

|

PD (PENDING)

|

Job tertahan, lihat [Daftar Job Reason]

|

CG (COMPLETING)

|

Job selesai dan dalam proses clean-up

|

CA (CANCELED)

|

Job dibatalkan user

|

PR (PREEMPETED)

|

Job dibatalkan admin, alasan dikabarkan via email

|

S (SUSPENDED)

|

Job ditahan admin, alasan dikabarkan via email

|

|

| 5

|

| User dapat memantau file output dengan perintah Unix seperti:

|

| 6

|

Apabila user ingin menghentikan job yang berjalan, jalankan perintah:

$ scancel [job-ID]

Job ID ada pada squeue diatas.

contoh membatalkan job ID 231:

$ scancel 231

|

| ---

|

| - Langkah Batch Job di EFIRO Job Composer -

|

| 0

|

| Apakah bisa menjalankan job?

|

User dengan Kredit Core Hour disarankan cek kuota terlebih dulu:

- Buka menu

Apps > Aleleon Shell Access

- Jalankan:

$ sausage

- Untuk akun institusi ikuti petunjuk support EFISON.

- Detail limit alokasi komputasi job lihat langkah 5B.

- Bila butuh tambah kuota, lihat [top up Kredit Core Hour]

|

| 1

|

| [Login ke web EFIRO] ALELEON Supercomputer.

|

| 2

|

|

Klik app Job Composer di homepage EFIRO.

- atau menu

Apps > Job Composer

|

|

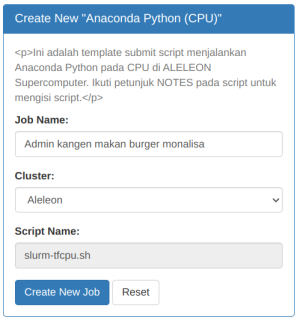

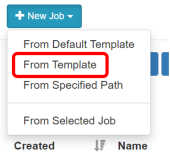

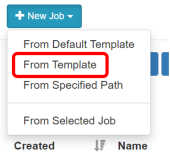

Pilih menu Pilih menu New Job > From Template

|

| 3

|

| Buat ruang job untuk menjalankan komputasi:

|

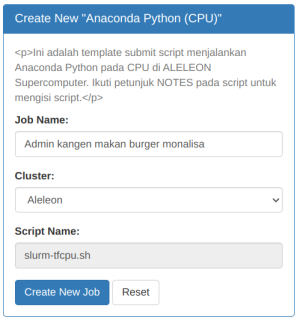

Pilih template OpenMX yang diinginkan:

| Nama Template

|

Penjelasan

|

| OpenMX 3.9.9

|

Menjalankan OpenMX 3.9.9

| Kemudian isi Job Name dan klik Create New Job

|

| 4

|

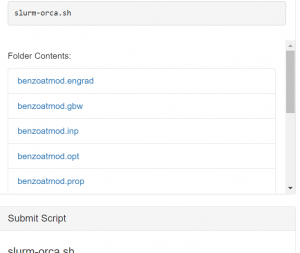

| Lakukan persiapan:

|

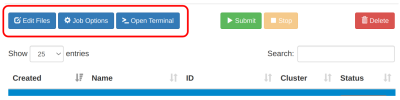

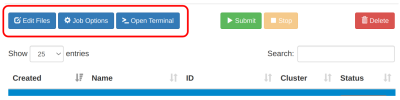

Siapkan file komputasi yang dibutuhkan di ruang job:

- Pastikan ruang job yang dipilih adalah yang akan digunakan.

- Upload / download / edit file via menu

Edit Files

- Upload / download file tunggal diatas 2GB gunakan [software FTP]

Perhatikan DATA.PATH pada file input.

|

| 5A

|

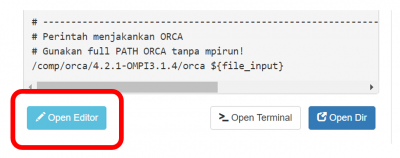

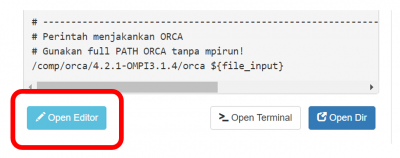

Lengkapi Submit Script melalui tombol Open Editor

- Submit script adalah 'formulir' untuk menjalankan job komputasi.

- Ikuti petunjuk NOTES dan alur script di dalamnya.

- Klik

Save setiap kali mengubah script.

|

OpenMX dapat dijalankan dengan opsi paralelisasi: OpenMX dapat dijalankan dengan opsi paralelisasi:

- MPI, OpenMP, atau hybid MPI / OMP.

- Detail lihat subbab [Pilihan MPI atau Threading OpenMP di OpenMX]

|

|

|

|

|

| 5B

|

SBATCH komputasi (ntasks, mem, time, dll) punya limit berdasarkan:

- Sisa Core Hour user dan [Fair Usage Limit]

- Spesifikasi sistem dan software komputasi.

Untuk melihat limit, jalankan perintah berikut:

$ slimit-hympi

Note untuk saat ini: Note untuk saat ini:

- Jalankan ketika tidak ada job user yang berjalan atau antri.

- Sementara berlaku untuk akun perseorangan saja.

|

| 6

|

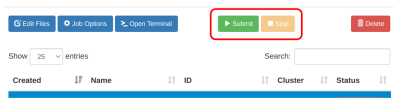

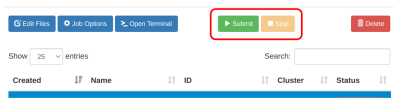

Jalankan job dengan klik tombol Submit

- Waktu jalan job tidak bergantung oleh alokasi limit waktu di script.

- Job berakhir ketika komputasi selesai atau ada error.

Kolom Status menunjukkan status jalannya job:

| Status

|

Arti

|

| Not Submitted

|

Job belum pernah dijalankan.

|

| Running

|

Job berjalan.

|

| Queue

|

Job mengantri dan belum berjalan.

|

| Completed

|

Job selesai berjalan.

|

| Failed

|

Job berhenti karena error atau di stop user.

|

| Melihat alasan job yang queue:

|

Buka menu Apps > Active Jobs di homepage EFIRO. Ubah opsi All jobs ke Your Jobs. Klik simbol > untuk melihat status job yang pending pada kolom Reason. Arti reason lihat laman Daftar Job Reason ALELEON Supercomputer |

|

| 7

|

Lihat output file komputasi pada kolom Folder Contents

- Atau dengan membuka menu

Edit Files

|

| 8

|

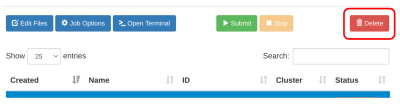

Apabila user ingin menghentikan job yang berjalan, klik Stop

|

| 9

|

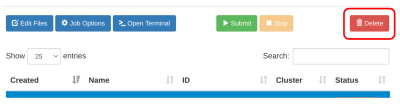

Untuk menghapus ruang job dan datanya:

- Pilih ruang job yang akan dihapus.

- Perhatikan opsi ini juga menghapus data di ruang job tersebut.

- Klik menu

Delete

|

| ---

|

Pilihan MPI atau Threading OpenMP untuk Menjalankan OpenMX

OpenMX di ALELEON Supercomputer dapat berjalan melalui paralelisasi MPI, OpenMP (OMP), atau keduanya (hybrid MPI/OMP) untuk menggunakan multi-core CPU dan multi-node. Admin menyerahkan keputusan kepada user untuk memilih metode paralelisasi melalui parameter Submit Script berikut:

- SBATCH ntasks mewakili jumlah task MPI sedangkan SBATCH cpus-per-task mewakili jumlah thread OMP.

#SBATCH --ntasks -> mewakili jumlah task MPI

#SBATCH --cpus-per-task -> mewakili jumlah thread OpenMP

- Apabila ingin MPI saja <Pure MPI>, isi jumlah SBATCH cpus-per-task dengan 1:

# Pure MPI

#SBATCH --ntasks=[isi-sesuai-keinginan]

#SBATCH --cpus-per-task=1

- Apabila ingin Hybrid MPI/OMP, isi kedua parameter tersebut:

- Total core CPU yang digunakan adalah ntasks * cpus-per-task.

- Contoh menggunakan 2 proses MPI dan 4 thread OMP per MPI sehingga total menggunakan 8 core CPU:

# Hybrid MPI/OMP, contoh dengan 2 proses MPI dan 4 thread OMP per MPI.

#SBATCH --ntasks=2

#SBATCH --cpus-per-task=4

- Apabila ingin OMP saja <Pure OMP>, isi jumlah ntasks dengan 1:

# Pure OMP

#SBATCH --ntasks=1

#SBATCH --cpus-per-task=[isi-sesuai-keinginan]

Pelaporan Kendala dan Support

Apabila menjumpai masalah teknis dalam menjalankan komputasi, silahkan lapor dengan klik gambar berikut ini.

---

Bila terdapat pertanyaan lainnya, silahkan hubungi admin EFISON melalui email:

support@efisonlt.com

Pilih menu

Pilih menu